1. ELMo(Embeddings from Language Model)

- 같은 표기의 단어라도 문맥에 따라서 다르게 워드 임베딩(Contextualized Word Embedding)을 할 수 있는 모델

2. biLM(Bidirectional Language Model)의 사전 훈련

- 순방향 언어모델과 역방향 언어모델이 각각의 은닉 상태만을 다음 은닉층으로 보내며 훈련시킨 후에 ELMo 표현으로 사용하기 위해서 은닉 상태를 연결(concatenate)시킴

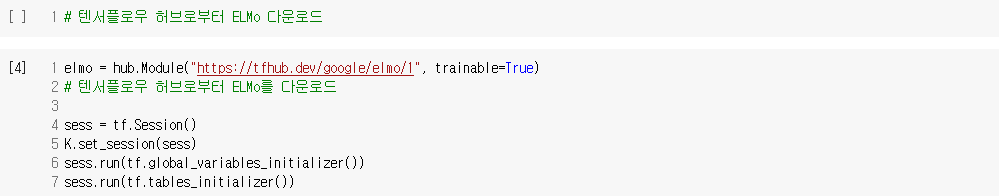

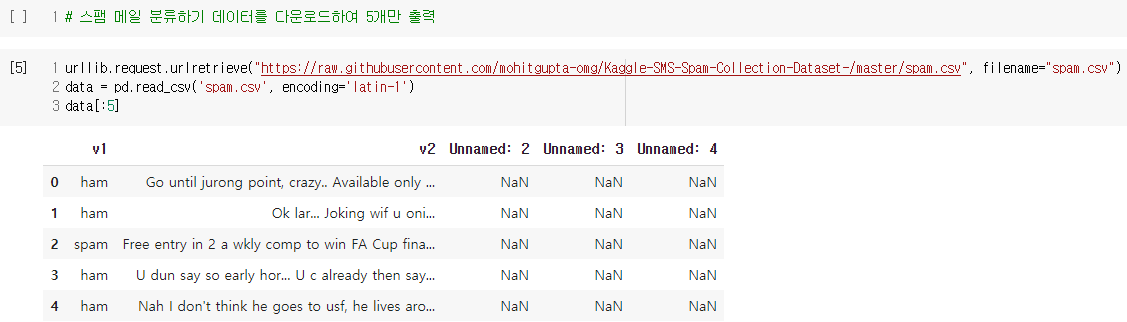

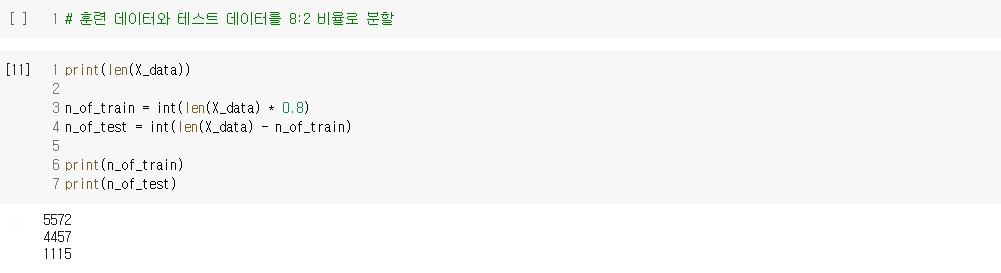

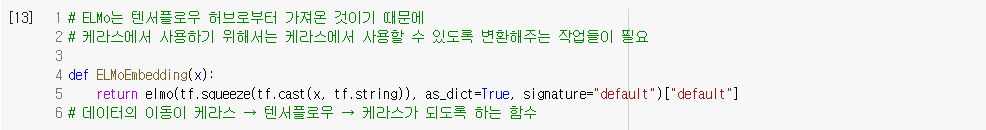

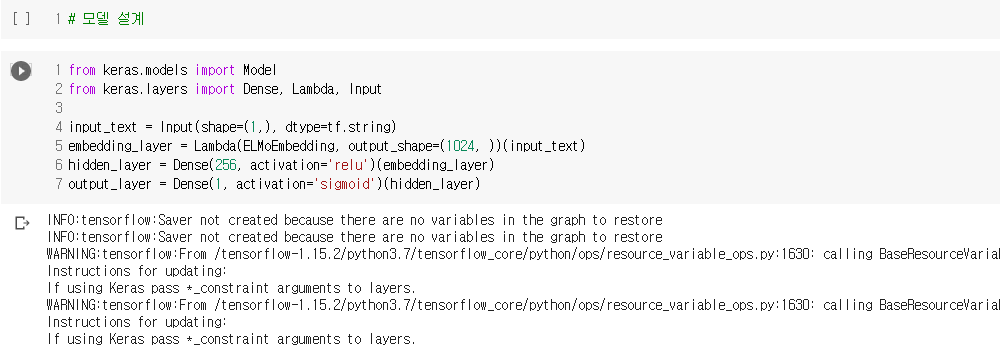

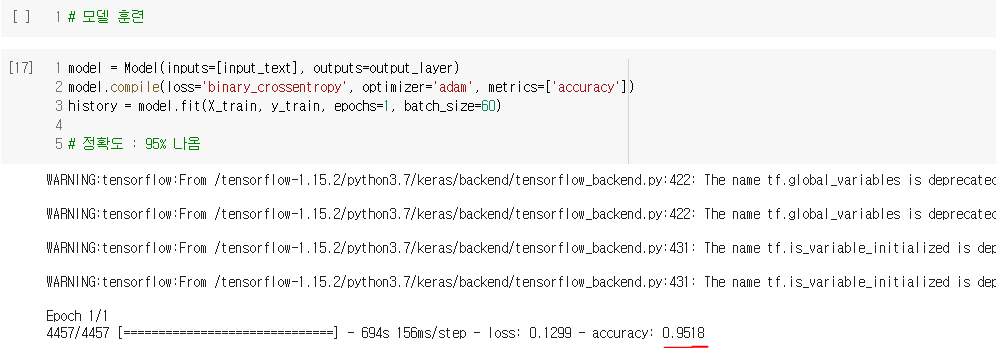

4. ELMo 표현(represenatation, 벡터)을 사용해서 스팸 메일 분류하기

- 텐서플로우 버전을 1로 다운그레이드 필요

- 출처 : [딥러닝을이용한 자연어 처리 입문] 1009 엘모(Embeddings from Language Model, ELMo)

'IT 와 Social 이야기 > NLP 자연어처리' 카테고리의 다른 글

| [딥러닝을이용한 자연어 처리 입문] 1012 워드 임베딩의 평균(Average Word Embedding) (0) | 2021.05.24 |

|---|---|

| [딥러닝을이용한 자연어 처리 입문] 1011 문서 벡터를 이용한 추천 시스템(Recommendation System using Document Embedding) (0) | 2021.05.24 |

| [딥러닝을이용한 자연어 처리 입문] 1008 사전 훈련된 워드 임베딩(Pre-trained Word Embedding) (0) | 2021.05.22 |

| [딥러닝을이용한 자연어 처리 입문] 1006 패스트텍스트(FastText) (0) | 2021.05.21 |

| [딥러닝을이용한 자연어 처리 입문] 1005 글로브(GloVe) (0) | 2021.05.21 |