- 출처 : [NIA] 와튼스쿨, '인공지능 위험과 대응 거버넌스' 주요 내용 - 김규리 선임연구원

1. 개요

○ 펜실베니아대 와튼스쿨의 ‘AI‧ML 위험 및 보안 실무그룹(AIRS)’은 AI 도입 시 고려해야 할 AI의 위험과 거버넌스에 관한 백서(white paper)를 발표(‘20.12.20)

○ AIRS는 본 보고서로 금융 서비스 회사가 AI 시스템 도입 시 고려해야 할 잠재적 위험을 살펴보고, 이를 완화할 수 있는 대응 거버넌스를 논의

- 각 기관‧서비스의 고유한 상황에 맞는 거버넌스 설계가 필요하므로 AIRS의 제안은 일종의 권고로 모든 상황을 포괄하거나 규범적인 내용이 아님

2. 주요 내용

- AI ML 시스템의 위험 및 위험 분류

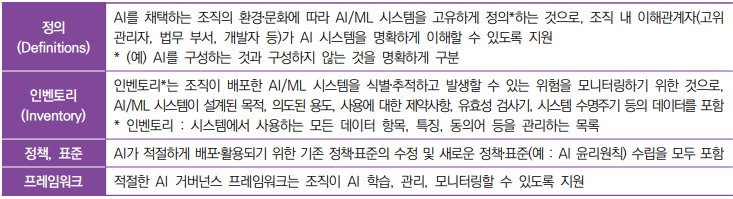

- AI 위험 관리를 위한 AI 거버넌스의 핵심 구성요소

- 차별 및 해석/설명 가능성

- (데이터로 인한 차별) 데이터를 통해 특정 계층을 식별 가능한 경우, 보호가 필요한 계층이 보호받지 못하거나 차등적 대우를 받으면 이를 차별로 볼 수 있음

- (알고리즘으로 인한 차별) 인간이 알고리즘을 식별‧검토하기엔 한계가 있어, 알고리즘 자체의 복잡성‧ 불투명성으로 인해 차별 발생 가능

- 인간 중심 방식(수동)으로 입력 데이터를 검토하고, 완화(mitigation) 알고리즘으로 결과의 품질‧차별에 대한 ‘최적’ 시스템을 찾아 차별을 완화 가능

- AI 시스템에 대한 해석가능성(Interpretability, 시스템 메커니즘을 직접 해석), 설명가능성(Explainability, 예측 결과에 대한 사후 설명)을 높여 위험을 낮출 수 있음

'기억하고 싶은 말들' 카테고리의 다른 글

| 당신은 도전자다 (0) | 2021.11.02 |

|---|---|

| [IITP] 영상 속 개인식별 정보 비식별화 기술 (0) | 2021.11.01 |

| [온라인새벽기도] 세상의 빛으로 사는 길 (1) | 2021.11.01 |

| 벨을 울려라 Ring The Bell (0) | 2021.11.01 |

| 조금 더 생각해보기 (0) | 2021.11.01 |