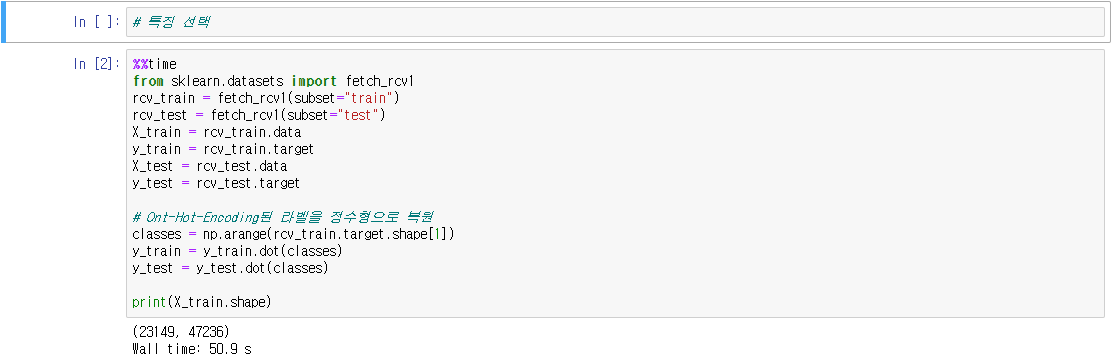

○ 특징데이터의 종류가 많은 경우에 가장 중요하다고 생각되는 특징데이터만 선택하여 특징데이터의 종류를 줄이기 위한 방법

dss_ml36_1_feature selection 특징 선택.ipynb

0.01MB

- 출처 : [데이터 사이언스 스쿨] 특징 선택

'IT 와 Social 이야기 > Python' 카테고리의 다른 글

| [데이터 사이언스 스쿨] 군집화 clustering (0) | 2021.05.14 |

|---|---|

| [데이터 사이언스 스쿨] 대규모 데이터 학습 (0) | 2021.05.14 |

| [데이터 사이언스 스쿨] 비대칭 데이터 문제 imbalanced data problem (0) | 2021.05.14 |

| [데이터 사이언스 스쿨] 모형 최적화 (0) | 2021.05.13 |

| [데이터 사이언스 스쿨] 커널 서포트 벡터 머신 (0) | 2021.05.13 |